Facebook AI研究部门在自然语言理解方面的最新突破名为XLM-R,可以处理诸多任务,比如针对包括斯瓦希里语和乌尔都语在内的100种不同语言解答问题。 这既表明深度学习模型变得越来越大,还表明它们遇到了现有计算系统中严重的资源瓶颈。

Facebook的巨型“XLM-R” 神经网络经过精心设计,可以 针对 包括斯瓦希里语和乌尔都语在内的100种不同语言 处理 单词问题,但 即便 使用500个 世界一流的英伟达 GPU,它也遇到了 计算 瓶颈 。

随着机器学习模型变得越来越大,最先进的AI研究继续遇到传统计算技术的瓶颈。

这是Facebook AI团队的研究人员最新的重大研究工作的成果之一。 上周,他们发布了有关其发明XLM-R的报告; XLM-R是一种自然语言模型,基于谷歌广受欢迎的Transformer模型。

题为《大规模的无监督跨语言表示学习》的论文( https://arxiv.org/pdf/1911.02116.pdf )发表在arXiv上,论文作者有Alexis Conneau、Kartikay Khandelwal Naman、Goyal Vishrav、Chaudhary Guillaume、Wenzek Francisco Guzmán、Edouard Grave、Myle Ott、Luke Zettlemoyer和Veselin Stoyanov,他们都是Facebook AI研究部门的人员。

XLM-R经过精心设计,能够在100种不同语言之间进行翻译。 它基于Conneau今年早些时候与Facebook的Guillaume Lample携手开展的工作,Facebook创建了最初的XLM。 他们写道,这与今年早些时候谷歌研究人员展示的对103种语言进行跨语言训练的那个系统极为相似。

与以前在各种基准测试任务(比如语言之间的问题解答)方面所做的研究工作相比,这是很大的改进。 尤其是,它在所谓的“低资源”语言方面取得了可喜的进步,这些语言没有太多的文字资料,比如斯瓦希里语和乌尔都语。

但是,尽管使用了500个功能最强大的英伟达GPU,XLM-R仍遇到了资源瓶颈。 论文作者们称之为“多语言诅咒”。 如果你将越来越多的语言填塞到单单一个端到端的Transformer中,低资源语言将从中受益,但到了一定程度,每种语言都遇到瓶颈。

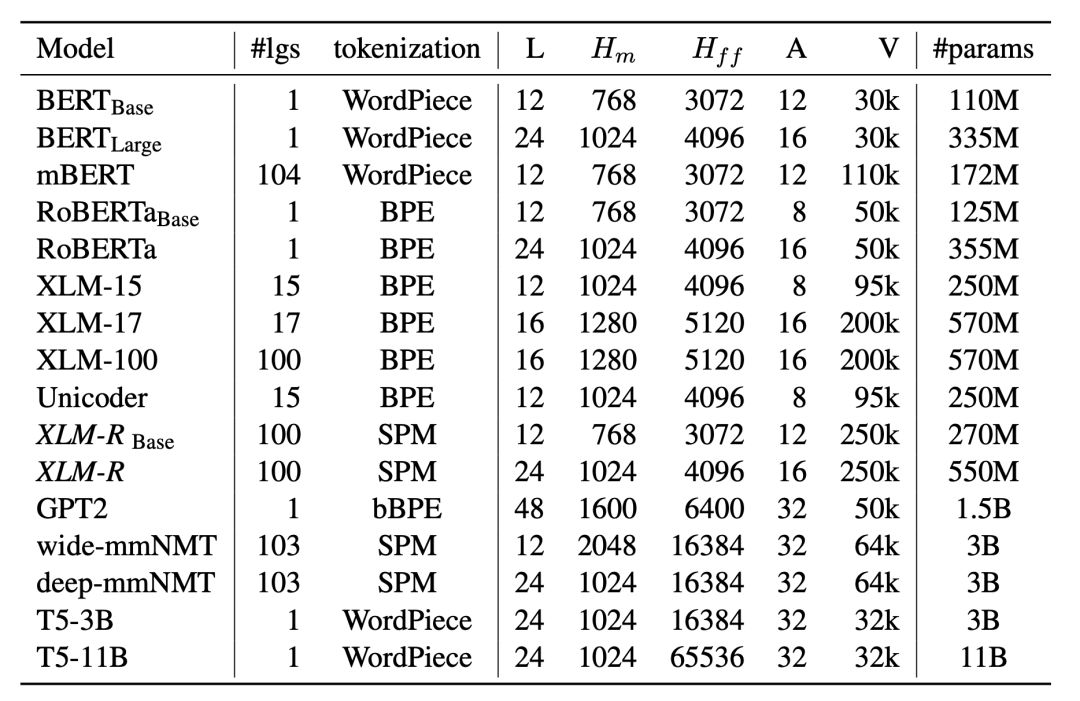

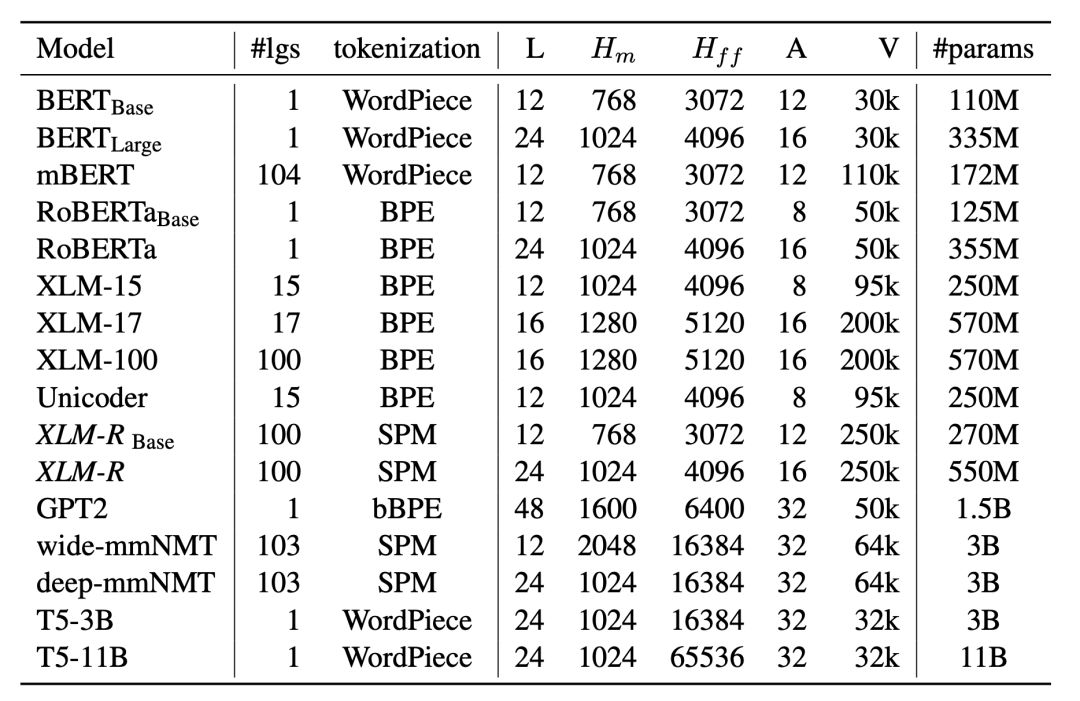

这是由于XLM-R很大,它有24层、16个“注意力头”以及5.5亿个参数,不过它仍然容量有限。 终究有一天,它可以处理要求它执行的各项任务。

作者们写道: “模型容量(即模型中参数的数量)由于实际考虑因素而受到限制,比如训练和推理过程中的内存和速度。 ”

XLM-R被要求处理大量的训练数据,即使用CommonCrawl程序从网上收集的2.5万亿字节数据。 XLM-R甚至还不是市面上最大的网络。 OpenAI今年早些时候推出的GPT2其最大版本有48层和15亿个参数。 正如Facebook的PyTorch负责人Joe Spisak今年初告诉IT外媒ZDNet,网络变得越来越大。

就总的参数数量或层数而言,Facebook的“XLM-R”并不是最大的网络,但它确实因将其许多参数专用于“单词”(token)而脱颖而出。 Token是指它可以处理的词汇量,总共是250000个单词。

但是XLM-R遇到了一些特定的瓶颈,比如可以容纳多大的词汇量。 论文作者构建的该系统以250000个“单词”作为基准,这已经比GPT-2的50000个单词要多,但是他们知道: 如果XLM-R拥有的单词多得多――意味着词汇量更大,可以变得更好。

论文作者写道: “有了更庞大的模型,我们认为使用多达200万个单词、并使用自适应softmax方法的词汇量有望进一步提升性能,但我们会在以后开展这项探究工作。 为了简单性起见,并鉴于计算资源方面的限制,我们为XLM-R使用了25万个单词的词汇量。 ”

单词是一个计算问题,因为使用更多的单词需要将模型的更多参数专用于神经网络的输入层,在输入层将单词嵌入为向量,而这意味着从网络的其他部分获取一些有限的参数容量。

XLM-R这个例子表明了深度学习领域的两个重要趋势。 一个趋势是,科学家们仍一心想构建越来越大的语言模型,以获得更好的基准测试结果。

而那些科学家继续遇到计算容量方面的瓶颈。 这是表明如果计算界要支持科学家们想要完成的事情,就不得不改变的另一个迹象。

特别声明:

文章来源:云头条

原文链接:https://mp.weixin.qq.com/s/pDdfOOG-nO6k4Sr4cXZxhg

RPA中国推荐阅读,转载此文是出于传递更多信息之目的。如有来源标注错误或侵权,请联系更正或删除,谢谢。

继续阅读:AI Facebook

未经允许不得转载:RPA中国 | RPA全球生态 | 数字化劳动力 | RPA新闻 | 推动中国RPA生态发展 | 流 > Facebook最新的庞大语言AI遭遇计算瓶颈,哪怕使用500个英伟达GPU!

热门信息

阅读 (14728)

1 2023第三届中国RPA+AI开发者大赛圆满收官&获奖名单公示阅读 (13753)

2 《Market Insight:中国RPA市场发展洞察(2022)》报告正式发布 | RPA中国阅读 (13055)

3 「RPA中国杯 · 第五届RPA极客挑战赛」成功举办及获奖名单公示阅读 (12964)

4 与科技共赢,与产业共进,第四届ISIG中国产业智能大会成功召开阅读 (11567)

5 《2022年中国流程挖掘行业研究报告》正式发布 | RPA中国